.

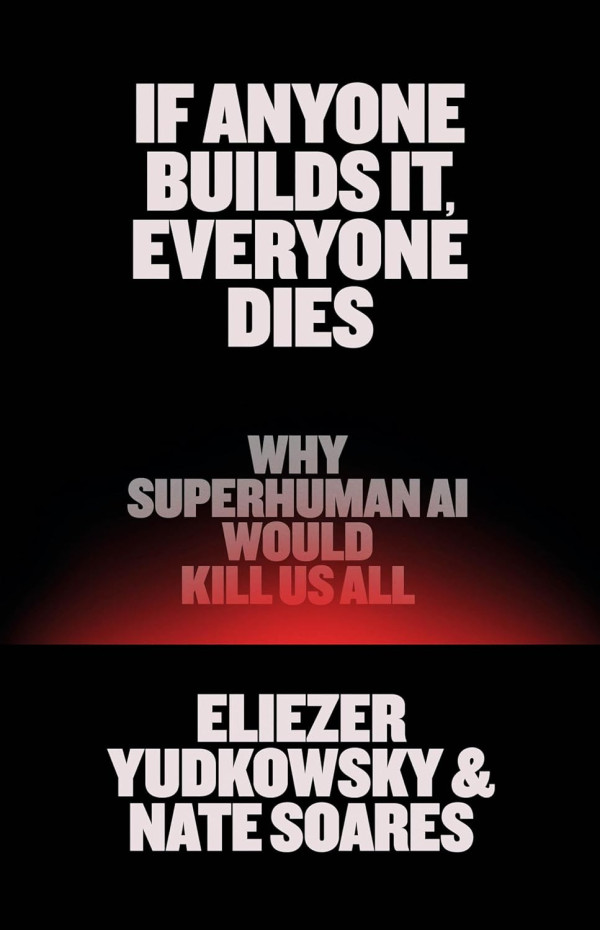

Este es el título de un libro reciente de Eliezer Yudkowsky y Nate Spares

Eliezer Yudkowsky lleva 20 años advirtiendo a los expertos en inteligencia artificial sobre los peligros que entraña.

Yudkowsky, de 46 años, es el fundador del Instituto de Investigación de Inteligencia Artificial, una organización sin fines de lucro con sede en Berkeley que estudia los riesgos de la inteligencia artificial avanzada.

El libro, coescrito con el presidente de MIRI, Nate Soares, es una versión condensada y para el mercado masivo de los argumentos que han estado presentando a los expertos en IA durante años.

Su objetivo es detener el desarrollo de la IA, y lo que está en juego, dicen, es existencial, nos puede llevar a la extinción.

“Si alguna empresa o grupo, en cualquier parte del planeta, construye una superinteligencia artificial usando algo remotamente parecido a las técnicas actuales, basándose en algo remotamente parecido a la comprensión actual de la IA, entonces todos, en todas partes en la Tierra, moriremos”, escriben.

Yudkowsky fue uno de los primeros en advertir sobre los riesgos de los potentes sistemas de IA, y muchos líderes en IA, como Sam Altman de OpenAI y Elon Musk, han estado de acuerdo y también han lanzado advertencias.

(Altman ha afirmado que Yudkowsky fue crucial en la decisión de fundar OpenAI y sugirió que podría merecer un Premio Nobel de la Paz).

Google también debe parte de su éxito en IA a Yudkowsky. O sea, el tipo sabe.

Fuente:

https://www.clarin.com/new-york-times-international-weekly/profeta-fatalidad-ia-quiere-acabar_0_0xwpMRkMs9.html

.

En 2023, cientos de eminencias de la IA firmaron una carta abierta advirtiendo que la inteligencia artificial representa un grave riesgo de extinción para la humanidad. Desde entonces, la carrera de la IA no ha hecho más que intensificarse. Empresas y países se apresuran a construir máquinas más inteligentes que cualquier persona. Y el mundo está terriblemente desprevenido para lo que vendrá después.

“La mejor explicación sencilla y sensata del problema del riesgo de la IA que he leído jamás”. —Yishan Wong, exdirector ejecutivo de Reddit

.

Disponible en Amazon:

https://www.amazon.com/Anyone-Builds-Everyone-Dies-Superhuman-ebook/dp/B0DZ1ZTPSM?&linkCode=sl1&tag=emersonspartz-20&linkId=133fb5157ba8d6daf0f70d02e9db1b7e&language=en_US